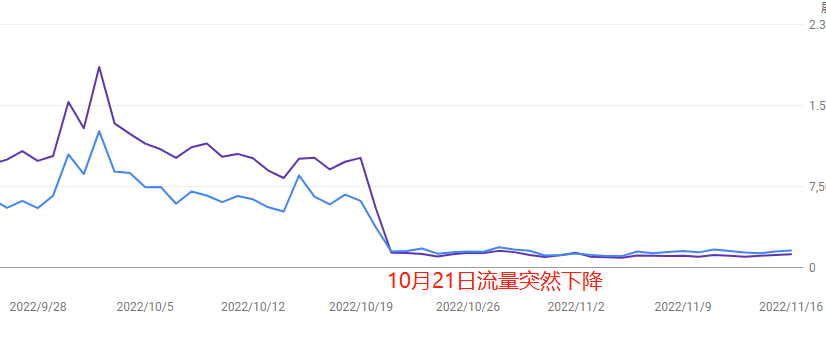

O tráfego do site subiu de repente e depois despencou — a primeira reação de muitos webmasters é: “Será que o algoritmo do Google mudou de novo?”

Mas na real, por trás dessas flutuações bruscas de tráfego, podem haver vários fatores — pode até ser um efeito colateral de alguma atualização de algoritmo, mas também pode ser problema técnico no próprio site, queda na qualidade do conteúdo, ou até manobra de concorrentes.

Neste artigo, vamos falar de forma prática sobre como identificar rapidamente se o problema veio do Google ou se é “incêndio no próprio quintal”, evitando mudanças às cegas que podem piorar a situação.

Table of Contens

TogglePrimeiro, veja se é culpa de uma atualização do Google

Quando o tráfego cai do nada, muitos donos de site logo pensam: “com certeza o Google atualizou o algoritmo”.

Mas colocar toda a culpa nisso pode te fazer ignorar problemas reais mais urgentes.

1. Veja o calendário oficial de atualizações do Google (com link para o blog do Search Central)

- Caminho: Acesse o blog oficial do Google Search Central (link aqui), clique em “What’s new in Google Search” e confira os registros dos últimos 3 meses. Atualizações importantes geralmente aparecem como “Core Update”, e outras mais específicas (como avaliações ou EEAT) são separadas.

- Fique esperto: Atualizações pequenas (como punições por links spam) às vezes não são divulgadas publicamente, então é bom comparar com ferramentas de monitoramento.

- Exemplo: Durante a Core Update de agosto de 2023, muitos sites de saúde e finanças perderam 30%–50% do tráfego por não terem autoridade suficiente no conteúdo.

2. Use ferramentas de SEO para analisar os picos (recomendo: SEMrush Sensor e RankRanger)

- Dica prática: No SEMrush Sensor, veja o “índice de volatilidade” nos 3 dias antes da queda de tráfego. Se passar de 7, é sinal de anomalia. Por exemplo: um site de ferramentas caiu 40% no dia 5 de setembro; o Sensor mostrava 8,2 no dia 3 — coincidindo com punições por backlinks suspeitos.

- Confirmação cruzada: Veja também a curva de “mudanças de posição” no Google Search Console. Se a queda nas taxas de cliques coincide com o Sensor, provavelmente é culpa do algoritmo.

3. Compare com sites concorrentes (use os gráficos do SimilarWeb)

- Como fazer: Vá no SimilarWeb, insira 3 domínios de concorrentes e selecione “Organic Traffic”. Se todos tiverem queda parecida (acima de 20%), pode ser efeito geral do algoritmo. Mas se só o seu site caiu, melhor investigar problemas internos primeiro.

- Dica fora do comum: Em alguns nichos (tipo review de hospedagem), os sites grandes podem ser favorecidos pelo Google e até subir de posição — então é bom analisar pelo menos os TOP 10 do segmento.

Faça uma checagem técnica urgente

Falhas técnicas precisam ser resolvidas em até 48 horas, senão o site pode perder posições por muito tempo.

1. Verifique o status do servidor (exemplo com Pingdom para monitorar quedas)

- Como fazer: Acesse o Pingdom ou o UptimeRobot (versão grátis monitora a cada 2 minutos), veja se houve “Downtime” (marcado em vermelho) nos horários de queda. Exemplo: um e-commerce caiu 3h durante uma grande promoção e perdeu 60% do tráfego orgânico.

- Fique ligado: Alguns problemas em CDN (como o Cloudflare) podem afetar só regiões específicas. Use o Geopeeker para testar acesso de várias localidades.

- O que fazer: Se detectar queda, entre em contato com sua hospedagem para escalar ou migrar o servidor, e envie no GSC uma solicitação de reindexação das URLs afetadas.

2. Teste a velocidade de carregamento da página (com captura do PageSpeed Insights)

- Métricas principais: Use o Google PageSpeed Insights na página que perdeu tráfego e olhe especialmente para o “LCP” (maior elemento visível). Se passar de 2,5s no mobile, o Google pode reduzir sua nota de “experiência da página”.

- Exemplo: Um blog deixou uma imagem de 3MB no topo da home e o carregamento no celular levou 8 segundos — o Google derrubou o ranking da página do segundo lugar para fora do top 100.

- Prioridades de otimização: Comprima imagens com o TinyPNG, ative o carregamento preguiçoso com o LazyLoad, e limpe CSS/JS desnecessários usando o PurgeCSS.

3. Estatísticas de erros de rastreamento (Relatório de Cobertura no Google Search Console)

- Onde encontrar os dados principais: Vá até o GSC → Cobertura → Aba “Erros”, filtre os erros críticos antes e depois da queda de tráfego, como “Bloqueado por robots.txt” ou “Erro de servidor (5xx)”. Se os erros diários aumentaram mais de 200%, pode ter ocorrido uma queda repentina na indexação.

- Armadilha oculta: Alguns plugins do WordPress podem alterar automaticamente o arquivo robots.txt (como bloquear /admin), fazendo com que o site inteiro fique inacessível ao rastreamento.

- O que fazer imediatamente: Use a ferramenta “Inspeção de URL” no GSC para solicitar um novo rastreamento; depois de corrigido, envie uma solicitação de validação.

Os algoritmos “punem” conteúdo fraco

A causa mais comum para uma queda de tráfego é o próprio conteúdo. Talvez você tenha conseguido tráfego por um tempo com conteúdo mediano ou gerado por IA, mas o Google — com BERT, MUM e outras ferramentas — está ficando cada vez melhor em identificar e punir esse tipo de página.

Isso geralmente acontece uma ou duas semanas após uma atualização de algoritmo, e a recuperação pode levar meses.

1. Verifique a proporção de conteúdo gerado por IA/copiar e colar (faça uma revisão manual de pelo menos 20% das páginas)

- Ferramentas úteis: Use Originality.ai ou GPTZero para analisar páginas com alta taxa de rejeição — preste atenção em trechos “bonitinhos mas superficiais” (como listas de 5 itens e excesso de conectores).

- Exemplo: Um blog tech criou 50 artigos “Como resolver erro XXX” usando o ChatGPT. No início teve um bom ranqueamento, mas após a atualização contra spam em outubro de 2023, o tráfego despencou.

- O que fazer: Se mais de 30% da página for conteúdo gerado por IA — adicione exemplos reais, entrevistas com usuários ou substitua parágrafos longos (300+ caracteres) por vídeos ou infográficos.

2. Taxa de rejeição de visitantes novos (em relatórios do GA4)

- Onde ver isso: No GA4, vá em “Aquisição → Páginas e Telas”, filtre as páginas que apareceram nos 30 dias antes da queda. Se a taxa de rejeição for 15% acima da média do site (ex: site = 50%, página = 65%), isso pode ter afetado o ranqueamento.

- Detalhe importante: Páginas com títulos muito chamativos podem ter um bom CTR, mas se o usuário sair em menos de 10 segundos, o algoritmo considera enganoso.

- Como melhorar: Adicione um sumário fixo, links para “soluções relacionadas”, ou elementos interativos para manter o visitante mais tempo.

3. Avalie a qualidade dos backlinks recentes (pelo Spam Score do Ahrefs)

- O que procurar: Use Ahrefs para ver os backlinks obtidos nos 2 meses antes da queda. Se o “Spam Score” for maior que 40/100 ou muitos links vierem da mesma IP C-Class (tipo 192.168.1.XX), isso pode gerar punição.

- Exemplo: Um site de turismo comprou 50 backlinks de fóruns de apostas no Camboja — o Google classificou como site “não confiável”.

- Como resolver: Envie um arquivo de desautorização pelo GSC e apague o conteúdo associado aos domínios problemáticos.

Concorrentes tomando ações diretas

Às vezes o problema não é o seu site — são concorrentes que começaram a disputar suas palavras-chave, pegaram seus snippets, ou lançaram anúncios nas mesmas keywords.

Ranking no Google é um jogo de soma zero: quando alguém sobe, outro cai.

1. Verifique se seus snippets foram tomados (busca manual pelas keywords principais)

- Como fazer: Use o modo anônimo do navegador e pesquise suas 3 palavras-chave mais importantes no Google. Se um concorrente aparece no snippet em destaque (caixa cinza) ou nas perguntas relacionadas e você não — significa que perdeu espaço.

- Exemplo: Um site de ferramentas PDF aparecia no snippet para “PDF converter”, mas um concorrente adicionou passos claros (“1. Upload → 2. Escolher formato → 3. Download”) + tabela comparativa e passou a receber 35% dos cliques.

- Como recuperar: Use AnswerThePublic para achar perguntas relacionadas, adicione seção de Q&A e organize o conteúdo com títulos H2/H3 e listas com passos.

2. Verifique o ritmo de publicação dos concorrentes (via Screaming Frog)

- Como investigar: Insira o domínio do concorrente no Screaming Frog, ative o filtro “Last Modified” e veja quais seções são mais atualizadas. Se a pasta /blog/ publica 5 artigos por dia, eles estão atacando sua área.

- Importante: Alguns só mudam a data do post sem mudar o conteúdo. Use o Diffchecker para comparar versões antigas e novas.

- Como reagir: Crie conteúdos de mais valor — relatórios, vídeos tutoriais, comparações de ferramentas, etc., focando na qualidade.

3. Veja se você perdeu tráfego por anúncios dos concorrentes (com histórico do SpyFu)

- Como descobrir: Vá ao SpyFu, insira o domínio do concorrente e veja em “Ad History” se eles rodaram anúncios no período da sua queda usando sua marca ou keywords (ex: “[seu nome] + alternativa”).

- Prova para denúncia: Use o SEMrush Advertising Research para capturar os anúncios. Se disserem algo como “Mais barato que XXX (você)” — pode violar as políticas do Google.

- Como se proteger: Adicione palavras-chave negativas no Google Ads, e destaque em seu site que você é o “site oficial”.

Recuperar o tráfego pode levar de 1 a 3 meses. Muitos pedidos de reavaliação podem parecer tentativa de manipulação manual.