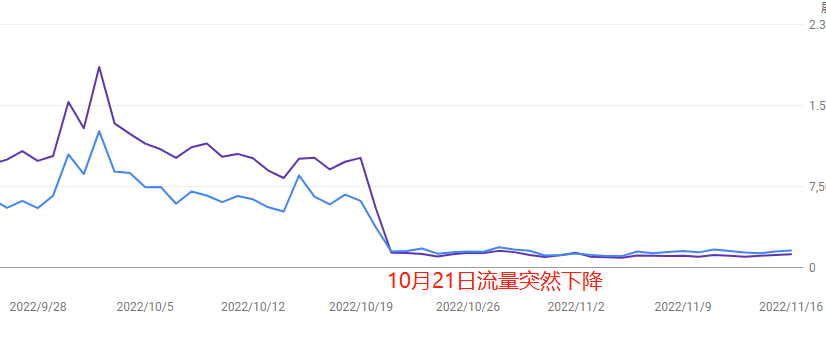

Gần đây, nhiều người có thể đã để ý thấy website của mình bị “tăng traffic đột ngột” trong vài ngày, sau đó lại rớt thê thảm. Điều đầu tiên mọi người nghĩ đến là: “Có phải Google lại cập nhật thuật toán nữa không?”

Nhưng thực ra, việc traffic lên xuống bất thường như vậy có thể do nhiều nguyên nhân phối hợp lại, chẳng hạn như bị ảnh hưởng gián tiếp từ thuật toán, sự cố kỹ thuật từ chính website, nội dung bị phát hiện là kém chất lượng, hoặc thậm chí bị đối thủ chơi xấu…

Bài viết này sẽ chia sẻ cách phân tích sơ bộ như một chuyên gia, giúp bạn xác định: “Liệu đây có phải là do Google cập nhật thuật toán hay do chính website mình có vấn đề?”, để tránh việc chỉnh sửa sai dẫn đến hậu quả nặng hơn.

Table of Contens

ToggleBước 1: Xác nhận xem có phải do Google cập nhật thuật toán không

Khi traffic giảm mạnh, hầu hết mọi người đều nghĩ ngay đến việc Google cập nhật thuật toán.

Nhưng nếu chỉ đổ lỗi cho Google mà không tìm hiểu kỹ, bạn có thể bỏ sót những nguyên nhân nguy hiểm hơn.

1. Xem lịch cập nhật chính thức của Google (trên blog Search Central)

- Cách kiểm tra: Truy cập blog Google Search Central, tìm mục “What’s new in Google Search” để xem các đợt cập nhật gần đây trong 3 tháng như “Core Update”, E-E-A-T hay Reviews đều được công bố rõ ràng.

- Lưu ý: Một số cập nhật nhỏ như spam link, spam content thường không được công bố, nên cần dùng thêm công cụ đo mức độ biến động để đối chiếu.

- Ví dụ: Trong Core Update tháng 8/2023, nhiều website về y tế và tài chính bị rớt hạng do nội dung thiếu độ tin cậy, lượng traffic giảm 30-50%.

2. Dùng công cụ SEO để xem có biến động hay không (gợi ý SEMrush Sensor và RankRanger)

- Điểm cần xem: Trong SEMrush Sensor, kiểm tra dữ liệu 3 ngày trước khi traffic giảm, nếu điểm “động đất” vượt quá 7 thì khả năng cao có cập nhật đang diễn ra.

- So sánh với Search Console: Vào Google Search Console kiểm tra biểu đồ vị trí trung bình và CTR. Nếu biến động trùng thời gian với điểm Sensor tăng mạnh thì có thể bạn bị ảnh hưởng bởi thuật toán.

3. So sánh với đối thủ (dùng SimilarWeb để xem xu hướng chung)

- Cách làm: Truy cập SimilarWeb, nhập domain của ít nhất 3 đối thủ để so sánh lượng traffic tự nhiên. Nếu cả nhóm cùng giảm hơn 20% trong thời gian bạn bị rớt thì khả năng cao là do cập nhật toàn ngành.

- Lưu ý: Một số ngành (như xếp hạng Hosting) Google có thể chỉ giữ TOP 3, nên cần kiểm tra cả TOP 10 để tránh đánh giá sai.

Bước tiếp theo: Kiểm tra xem có lỗi kỹ thuật nào không

Golden Time để khôi phục thứ hạng do lỗi kỹ thuật là “trong vòng 48 giờ”. Quá thời gian này, khả năng hồi phục sẽ thấp hơn nhiều.

1. Kiểm tra tình trạng server (dùng Pingdom hoặc UptimeRobot xem lịch sử downtime)

- Cách kiểm tra: Đăng nhập vào Pingdom hoặc UptimeRobot để xem có thời gian nào website bị “sập” (dải đỏ) trùng với thời điểm traffic giảm không. Ví dụ một website bán hàng bị sập 3 giờ trong đợt khuyến mãi khiến traffic giảm 60% ngay lập tức.

- Với Cloudflare: Nếu dùng Cloudflare hoặc CDN thì có thể chỉ một số khu vực không truy cập được. Nên dùng Geopeeker để test từ nhiều quốc gia.

- Khắc phục: Nếu phát hiện downtime thật, hãy liên hệ nhà cung cấp để nâng cấp server hoặc chuyển hosting. Sau đó dùng GSC để gửi yêu cầu index lại URL.

2. Kiểm tra tốc độ tải trang (dùng PageSpeed Insights)

- Tiêu chí chính: Truy cập PageSpeed Insights, kiểm tra các trang bị giảm traffic. LCP (Largest Contentful Paint) không nên quá 2.5 giây. Nếu điểm Mobile dưới 50 thì nguy cơ bị ảnh hưởng từ Page Experience rất cao.

- Ví dụ: Một blog dùng ảnh 3MB khiến trang tải trên điện thoại mất hơn 8 giây, bị tụt về trang 2 ngay lập tức.

- Cách tối ưu: Nén ảnh (gợi ý dùng TinyPNG), kích hoạt Lazy Load (dùng plugin LazyLoad), xóa CSS/JS dư thừa (dùng PurgeCSS).

3. Kiểm tra lỗi thu thập dữ liệu (GSC → báo cáo Coverage)

- Cách kiểm tra: Vào Google Search Console, chọn mục “Coverage”, xem tab “Error” để xem có lỗi nào tăng đột biến trong thời gian traffic giảm không, như “bị chặn bởi robots.txt”, “lỗi server 5xx”… Nếu lỗi tăng trên 200% trong một ngày thì rất đáng lo.

- Lưu ý: Một số plugin WordPress có thể tự sửa robots.txt sau khi cập nhật, ví dụ chỉ định chặn /admin nhưng lại chặn cả site.

- Khắc phục: Dùng công cụ URL Inspection của GSC để gửi lại URL bị lỗi, sau đó nhấn “Validate Fix”.

3. Lỗi thu thập dữ liệu (báo cáo Coverage trong Google Search Console)

- Chỗ nên kiểm tra đầu tiên: Vào GSC → Coverage → tab “Error”, xem trước và sau thời điểm traffic giảm có lỗi kiểu “Đã gửi URL nhưng bị chặn bởi robots.txt” hoặc “Lỗi máy chủ (5xx)” không. Nếu lỗi thu thập dữ liệu tăng hơn 200% trong 1 ngày thì có thể là lý do khiến số lượng trang được index giảm đột ngột.

- Lỗi thường bị bỏ sót: Đôi khi plugin WordPress sau khi cập nhật sẽ vô tình ghi đè file robots.txt, ví dụ như tự dưng chặn thư mục “/admin” làm bot không thể crawl toàn bộ website.

- Cách xử lý nhanh: Dùng công cụ “Kiểm tra URL” trong GSC để yêu cầu bot thu thập lại, sau đó nhấn “Yêu cầu xác minh đã khắc phục”.

Chất lượng nội dung có thể bị thuật toán xử phạt trễ

Một lý do dễ bị bỏ qua khi traffic giảm mạnh chính là bản thân nội dung. Có lúc nội dung kém chất lượng vẫn có thể tạo được traffic cao trong thời gian ngắn, nhưng sau một thời gian, Google dùng AI như BERT hoặc MUM sẽ bắt đầu “xử lý có độ trễ” chính xác hơn, khiến các trang từng không bị ảnh hưởng nay bị đánh tụt hạng.

Việc bị phạt trễ thường xảy ra sau cập nhật thuật toán khoảng 1–2 tuần, và có thể mất vài tháng để phục hồi.

1. Kiểm tra tỷ lệ nội dung do AI tạo ra hoặc sao chép (gợi ý kiểm tra ngẫu nhiên 20% tổng số trang)

- Công cụ kiểm tra: Dùng Originality.ai hoặc GPTZero để quét các trang có Bounce rate cao, tìm các đoạn văn trơn tru nhưng thiếu thông tin thực chất (ví dụ: lặp lại 5 đoạn tương tự, hoặc dùng từ nối quá nhiều).

- Ví dụ thực tế: Một blog công nghệ đã dùng ChatGPT để tạo hơn 50 bài “Cách sửa lỗi XXX”, ban đầu thứ hạng rất tốt, nhưng sau khi Google ra bản Core Update tháng 10/2023 để xử lý nội dung kém chất lượng, traffic giảm một nửa.

- Cách xử lý nhanh: Nếu một trang có nội dung do AI tạo hơn 30%, nên bổ sung ví dụ thực tế, phỏng vấn người dùng, và thay các đoạn dài (trên 300 ký tự) thành video hoặc infographic.

2. Kiểm tra Bounce rate của các trang mới (trong báo cáo GA4 > Engagement)

- Cách xem: Vào GA4 → Acquisition → Pages and Screens, lọc các trang mới thêm trong 30 ngày trước thời điểm traffic giảm. Nếu Bounce rate cao hơn trung bình >15% (ví dụ: trung bình 50%, trang đó 65%) thì có thể khiến điểm SEO giảm.

- Lỗi phổ biến: Nội dung dùng tiêu đề kiểu clickbait có thể thu hút nhấp chuột, nhưng nếu người dùng thoát sau chưa đầy 10 giây, Google sẽ đánh giá là “nội dung lừa người”.

- Mẹo cải thiện: Thêm anchor link mục lục hoặc popup “gợi ý bài viết liên quan” để giữ người đọc ở lại trang lâu hơn.

3. Kiểm tra chất lượng backlink tăng đột biến (dùng chỉ số Spam Score trong Ahrefs)

- Dấu hiệu nguy hiểm: Dùng Ahrefs kiểm tra backlink trong 2 tháng trước khi traffic giảm. Nếu Spam Score >40/100 hoặc có nhiều backlink từ cùng một IP class C (ví dụ: 192.168.1.XX) thì nguy cơ bị Google xử phạt là cao.

- Trường hợp thực tế: Một website du lịch mua hơn 50 backlink từ các diễn đàn “casino Campuchia” để tăng DA, nhưng bị Google đánh giá là nguồn không đáng tin cậy.

- Giải pháp: Gửi file Disavow trong Google Search Console và xóa nội dung liên quan đến các backlink rác đó.

Bị đối thủ cạnh tranh “tấn công” có chủ đích

Đôi khi traffic giảm không phải do lỗi của mình, mà là do đối thủ làm SEO vượt mặt, cập nhật nội dung hàng loạt hoặc chạy quảng cáo để chiếm traffic.

SEO là cuộc chơi có lên có xuống – khi đối thủ lên, thì mình sẽ bị tụt.

1. Kiểm tra có bị cướp Featured Snippet không (tìm keyword chính thủ công)

- Cách kiểm tra: Mở trình duyệt ẩn danh, tìm 3 từ khóa chính. Nếu đối thủ chiếm Featured Snippet (ô màu xám có câu trả lời) hoặc nằm trong mục “Người cũng hỏi” và web mình rớt xuống top 2 trở đi, tức là đã mất một phần traffic.

- Ví dụ thực tế: Một trang chuyển đổi PDF từng giữ Snippet với từ khóa “PDF converter”, nhưng đối thủ tạo trang hướng dẫn từng bước “① Tải lên → ② Chọn định dạng → ③ Tải xuống” kèm bảng so sánh, chiếm 35% traffic chỉ trong 7 ngày.

- Cách đối phó: Dùng AnswerThePublic tìm các câu hỏi dài (long-tail), rồi thêm Q&A và danh sách đánh số với thẻ H2/H3 vào trang.

2. So sánh tần suất cập nhật nội dung của đối thủ (dùng Screaming Frog)

- Cách kiểm tra: Nhập domain của đối thủ vào Screaming Frog, lọc theo “Last Modified” để xem thư mục nào cập nhật thường xuyên trong 1 tháng gần đây. Ví dụ: nếu thư mục /blog/ của họ đăng 5 bài/ngày và nội dung trùng với của mình thì có thể mình đang bị “tấn công bằng nội dung”.

- Lưu ý: Một số trang chỉ thay đổi ngày đăng nhưng không cập nhật nội dung. Nên dùng Diffchecker để so sánh thật sự có thay đổi không.

- Cách phản công: Với các chủ đề bị cạnh tranh mạnh, hãy làm nội dung chuyên sâu hơn như báo cáo nghiên cứu, video hướng dẫn hoặc biểu đồ so sánh công cụ.

3. Kiểm tra có bị giành traffic bằng quảng cáo không (xem lịch sử quảng cáo qua SpyFu)

- Công cụ kiểm tra: Dùng SpyFu, nhập domain đối thủ rồi xem mục “Ad History” để xem trong thời gian traffic giảm, họ có chạy quảng cáo với tên brand hoặc từ khóa chính của mình không.

- Cách thu thập bằng chứng: Dùng SEMrush hoặc công cụ xem trước quảng cáo để chụp lại nội dung quảng cáo so sánh kiểu “rẻ hơn XXX” rồi báo cáo vi phạm chính sách Google Ads.

- Cách phòng ngừa: Đặt từ khóa loại trừ (Exclude Keyword) là tên thương hiệu mình trong Google Ads, và thêm dấu xác thực thương hiệu trên landing page để tăng độ tin cậy.

Thông thường, việc phục hồi traffic sẽ mất khoảng 1–3 tháng. Đừng gửi yêu cầu xem xét lại quá nhiều lần vì có thể bị Google đánh giá là “spam hệ thống”.