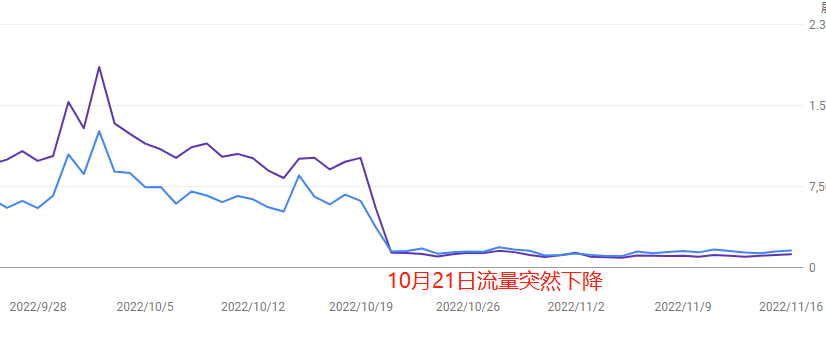

เมื่อเร็วๆ นี้ หลายคนอาจสังเกตว่าเว็บไซต์ตัวเอง “ทราฟฟิกพุ่งสูงขึ้น” อยู่ไม่กี่วัน แล้วก็ตกลงอย่างรวดเร็ว สิ่งแรกที่คนส่วนใหญ่คิดก็คือ “หรือว่า Google ปรับอัลกอริธึมอีกแล้ว?”

แต่จริงๆ แล้ว การที่ทราฟฟิกขึ้นๆ ลงๆ อย่างรวดเร็วแบบนี้ อาจมาจากหลายสาเหตุผสมกัน ไม่ว่าจะเป็นโดนอัลกอริธึมแบบ “ลูกหลง”, ปัญหาทางเทคนิคของเว็บไซต์เอง หรือแม้กระทั่งคุณภาพคอนเทนต์ที่ถูกจับได้ว่าไม่ผ่าน หรือในบางกรณีอาจมีคู่แข่งเข้ามาก่อกวนก็ได้…

บทความนี้จะมาแชร์ขั้นตอนการวิเคราะห์เบื้องต้นแบบมืออาชีพ ว่าจะรู้ได้ยังไงว่า “นี่เป็นเพราะ Google ปรับอัลกอริธึมหรือเปล่า หรือว่าเป็นปัญหาภายในของเราเอง” เพื่อช่วยให้คุณตัดสินใจได้เร็ว และหลีกเลี่ยงการปรับเว็บแบบผิดๆ ที่อาจทำให้เจ็บตัวหนักกว่าเดิม

Table of Contens

Toggleขั้นแรก: ตรวจสอบก่อนว่าเป็นเพราะ Google ปรับอัลกอริธึมหรือเปล่า

พอทราฟฟิกลดลง หลายคนก็จะคิดทันทีว่า “สงสัย Google ปรับอัลกอริธึมอีกแล้วแน่ๆ”

แต่ถ้าเรามัวแต่โทษ Google อย่างเดียว อาจจะพลาดสาเหตุที่แท้จริงที่ร้ายแรงกว่านั้นได้

1. เช็กปฏิทินอัปเดตของ Google โดยตรง (ดูจากบล็อก Search Central)

- วิธีเช็ก: เข้าไปที่บล็อก Google Search Central ดูในหมวด “What’s new in Google Search” จะมีรายการอัปเดตล่าสุดของช่วง 3 เดือนหลังสุด เช่น “Core Update” สำหรับอัปเดตหลัก และพวก E-E-A-T หรือ Reviews จะเขียนแยกไว้

- ข้อควรระวัง: การอัปเดตเล็กๆ อย่างพวก spam link หรือ spam content อาจไม่มีประกาศอย่างเป็นทางการ ต้องเช็กเครื่องมือวัดแรงสั่นสะเทือนควบคู่ไปด้วย

- ตัวอย่าง: ใน Core Update เดือน ส.ค. 2023 เว็บไซต์ในสายการแพทย์ การเงินหลายแห่งโดนลดอันดับ เพราะความน่าเชื่อถือของเนื้อหาไม่พอ ทราฟฟิกลด 30-50%

2. ใช้เครื่องมือ SEO เช็กว่ามีการเปลี่ยนแปลงอะไรไหม (แนะนำ SEMrush Sensor และ RankRanger)

- จุดสังเกต: ใน SEMrush Sensor ให้ดูช่วง 3 วันก่อนทราฟฟิกลด ถ้าคะแนน “ความสั่นสะเทือน” เกิน 7 ขึ้นไป แปลว่ามีความเป็นไปได้สูงว่ามีการอัปเดตเบื้องหลัง

- เทียบกับ Search Console: ลองเปิด Google Search Console ดูกราฟตำแหน่งเฉลี่ยและ CTR ถ้าช่วงเปลี่ยนแปลงตรงกับช่วงคะแนน Sensor ขึ้นแรงๆ ก็มีแนวโน้มว่าเว็บคุณได้รับผลกระทบจากอัลกอริธึม

3. เปรียบเทียบกับเว็บคู่แข่ง (ใช้ SimilarWeb เช็กแนวโน้ม)

- วิธีทำ: เข้าไปที่ SimilarWeb ใส่โดเมนของคู่แข่ง 3 รายขึ้นไป ดูกราฟทราฟฟิกเฉพาะ Organic เทียบกัน ถ้าช่วงที่เว็บคุณตก เว็บคู่แข่งก็ตก 20% ขึ้นไปพร้อมกัน แปลว่าเป็นการอัปเดตระดับอุตสาหกรรม

- ข้อควรระวัง: บางอุตสาหกรรม (เช่น เว็บไซต์จัดอันดับ Hosting) Google อาจจะดันเฉพาะ TOP 3 เท่านั้น ต้องเช็กทั้ง TOP 10 จะได้ไม่สรุปผิด

ต่อไป: รีบเช็กว่ามีปัญหาทางเทคนิคในเว็บไซต์หรือไม่

Golden Time ในการกู้คืนอันดับเว็บจากปัญหาเทคนิคคือ “ภายใน 48 ชั่วโมง” ถ้าช้าเกินไป อาจฟื้นไม่ทัน

1. เช็กสถานะเซิร์ฟเวอร์ (ใช้ Pingdom หรือ UptimeRobot ดูประวัติ downtime)

- วิธีดู: เข้าระบบ Pingdom หรือ UptimeRobot ดูว่าช่วงเวลาที่ทราฟฟิกลด มีการ “ล่ม” (แถบสีแดง) หรือไม่ เช่น เว็บขายของเว็บหนึ่ง ล่มตอนจัดโปรโมชันใหญ่ไป 3 ชั่วโมง ทราฟฟิกลดลง 60% ทันที

- กรณี Cloudflare: ถ้าใช้ Cloudflare หรือ CDN อาจมีบาง region เท่านั้นที่เข้าเว็บไม่ได้ แนะนำใช้ Geopeeker เพื่อดูจากหลายประเทศ

- วิธีแก้: ถ้าเจอ downtime จริง รีบแจ้งโฮสให้ขยายหรือย้ายเซิร์ฟเวอร์ แล้วใช้ GSC ส่ง URL request ใหม่เพื่อให้ Google กลับมาเก็บข้อมูล

2. เช็กความเร็วการโหลดหน้าเว็บ (ใช้ PageSpeed Insights)

- จุดสังเกตหลัก: ใช้ PageSpeed Insights ตรวจหน้าเพจที่ทราฟฟิกลด LCP (Largest Contentful Paint) ไม่ควรเกิน 2.5 วินาที ถ้าคะแนนมือถือ (Mobile Score) ต่ำกว่า 50 ถือว่าเสี่ยงโดนลดอันดับจาก Page Experience

- ตัวอย่าง: บล็อกแห่งหนึ่งใช้รูปภาพ 3MB บนมือถือโหลดเกิน 8 วินาที ตกไปอันดับ 2 หน้า 2 ทันที

- วิธีปรับปรุง: บีบอัดรูป (แนะนำ TinyPNG), ใช้ Lazy Load (แนะนำ ปลั๊กอิน LazyLoad), ลบ CSS/JS ที่ไม่จำเป็น (แนะนำ PurgeCSS)

3. ตรวจสอบ error การเก็บข้อมูล (GSC → รายงาน Coverage)

- วิธีดู: เข้า Google Search Console ไปที่เมนู “Coverage” เลือกแท็บ “Error” ดูว่าช่วงที่ทราฟฟิกลด มี error อย่าง “ถูก block โดย robots.txt”, “5xx server error” พุ่งขึ้นหรือเปล่า ถ้า error เพิ่มเกิน 200% ในวันเดียวกัน ถือว่าอันตราย

- ข้อควรระวัง: อัปเดตปลั๊กอินใน WordPress บางครั้งจะไปแก้ robots.txt โดยอัตโนมัติ เช่น ตั้งใจบล็อก /admin แต่ดันไปบล็อกทั้งเว็บ

- วิธีแก้: ใช้ URL Inspection Tool ของ GSC ส่ง URL ที่ error ไปให้ Google ตรวจใหม่ แล้วกด “Validate Fix”

3. สถิติข้อผิดพลาดในการถูกรวบรวมข้อมูล (รายงาน Coverage ของ Google Search Console)

- จุดที่ควรเช็กก่อน: ไปที่ GSC → Coverage → แท็บ “Error” แล้วดูว่าก่อนและหลังวันที่ทราฟฟิกตกมี error ประเภท “ส่ง URL แต่ถูกบล็อกจาก robots.txt” หรือ “Server error (5xx)” หรือเปล่า ถ้าข้อผิดพลาดจากการรวบรวมข้อมูลเพิ่มขึ้นเกิน 200% ภายในวันเดียว ก็อาจเป็นสาเหตุให้จำนวนหน้าที่ถูก index ลดลงฮวบเลย

- จุดพลาดที่ไม่คาดคิด: บางทีปลั๊กอิน WordPress ที่อัปเดตอาจเขียนทับ robots.txt โดยไม่ตั้งใจ เช่น อยู่ดี ๆ ไปบล็อกไดเรกทอรี “/admin” แล้วทำให้บอตเข้าเว็บไม่ได้ทั้งเว็บ

- วิธีแก้ด่วน: ใช้เครื่องมือ “ตรวจสอบ URL” ของ GSC เพื่อขอให้บอตเข้าใหม่ แล้วกด “ขอยืนยันการแก้ไข” หลังแก้ไขเสร็จ

คุณภาพคอนเทนต์อาจโดนอัลกอริทึมลงโทษแบบ “ดีเลย์”

สาเหตุที่คนมักมองข้ามเวลาทราฟฟิกลดแรง ๆ ก็คือ “คอนเทนต์เอง” บางทีเนื้อหาคุณภาพต่ำอาจพาให้มีทราฟฟิกพุ่งช่วงสั้น ๆ แต่พอผ่านไปสักพัก Google ที่ใช้ AI อย่าง BERT หรือ MUM ก็จะเริ่ม “ลงโทษแบบหน่วงเวลา” ได้แม่นยำขึ้น หน้าเพจที่เคยไม่โดนอะไรเลยก็เริ่มได้รับผลกระทบ

การโดนแบบ “ดีเลย์” มักจะเกิดหลังจากอัลกอริทึมอัปเดตประมาณ 1–2 สัปดาห์ และบางทีใช้เวลาฟื้นตัวเป็นเดือน

1. ตรวจสัดส่วนคอนเทนต์ที่สร้างจาก AI หรือรวบรวมมา (แนะนำสุ่มตรวจ 20% ของเพจทั้งหมด)

- เครื่องมือตรวจจับ: ใช้ Originality.ai หรือ GPTZero สแกนเพจที่ Bounce rate สูงๆ มองหาย่อหน้าที่ลื่นเกินจริงแต่เนื้อหาไม่มีสาระ (เช่น ย่อหน้า 5 ส่วนซ้ำ ๆ กัน หรือใช้คำเชื่อมบ่อยเกิน)

- เคสตัวอย่าง: บล็อกเทคโนโลยีแห่งหนึ่งปั่นบทความ “วิธีแก้ XXX error” ด้วย ChatGPT กว่า 50 บท ตอนแรกติดอันดับดี แต่หลังโดน Core Update ต.ค. 2023 ที่จัดการคอนเทนต์คุณภาพต่ำ ทราฟฟิกลดไปครึ่งหนึ่ง

- วิธีแก้ด่วน: ถ้าหน้าไหนมีคอนเทนต์จาก AI เกิน 30% ให้เติมเคสจากประสบการณ์จริงหรือบทสัมภาษณ์ผู้ใช้ และแนะนำเปลี่ยนย่อหน้าใหญ่ ๆ (300 ตัวอักษรขึ้นไป) ให้เป็นวิดีโอหรืออินโฟกราฟิกแทน

2. ดู Bounce rate ของหน้าเพจใหม่ (ดูจากรายงาน GA4 > การใช้งาน)

- วิธีดู: ไปที่ GA4 → การได้มา → เพจและหน้าจอ แล้วฟิลเตอร์หาเพจที่เพิ่มเข้ามาในช่วง 30 วันก่อนวันที่ทราฟฟิกลด หาก Bounce rate ของเพจนั้นสูงกว่าค่าเฉลี่ยเกิน 15% (เช่น โดยรวม 50% แต่เพจนั้น 65%) ก็อาจทำให้คะแนนอันดับตกได้

- เทรนด์ที่มักพลาด: คอนเทนต์ที่ใช้หัวข้อ Clickbait บางทีก็คลิกเยอะจริงแต่ผู้ใช้อยู่ไม่ถึง 10 วินาที ทำให้ Google มองว่าเป็น “คอนเทนต์ที่หลอกลวง”

- เคล็ดลับ: เพิ่ม Anchor link สำหรับสารบัญ หรือใส่ป๊อปอัป “แนะนำบทความอื่น” เพื่อให้ผู้ใช้อยู่บนเพจนานขึ้น

3. ตรวจคุณภาพ Backlink ที่เพิ่มขึ้นเร็วผิดปกติ (ใช้คะแนน Spam Score ของ Ahrefs)

- สัญญาณเตือน: ใช้ Ahrefs เช็กลิงก์ย้อนกลับที่ได้มาในช่วง 2 เดือนก่อนที่ทราฟฟิกลด ถ้ามี Spam score เกิน 40/100 หรือมีลิงก์จาก IP class C เดียวกัน (เช่น 192.168.1.XX) เยอะ ๆ ก็เสี่ยงโดนลงโทษได้

- เคสอันตราย: เว็บท่องเที่ยวแห่งหนึ่งซื้อ Backlink จากฟอรัม “คาสิโนในกัมพูชา” กว่า 50 ลิงก์เพื่อเพิ่ม DA แล้วโดน Google มองว่าเป็นแหล่งที่ไม่น่าเชื่อถือ

- แนวทางแก้: ส่งไฟล์ Disavow ลิงก์ใน Google Search Console แล้วลบเนื้อหาที่เชื่อมโยงกับลิงก์สแปมออก

โดนคู่แข่งโจมตีแบบตั้งใจ

บางครั้งทราฟฟิกลดไม่ใช่เพราะเราพลาดเอง แต่อาจเป็นเพราะคู่แข่งทำ SEO แซงหน้าเราไป หรืออัปเดตคอนเทนต์ยกแผง หรือซื้อโฆษณามากินทราฟฟิกเราแทน

การติดอันดับ SEO เป็นเกมที่ใครได้ใครเสีย ถ้าคู่แข่งขึ้น อันดับเราก็จะลง

1. ตรวจว่าโดนแย่ง Featured Snippet หรือไม่ (ค้นหาคีย์เวิร์ดหลักแบบ Manual)

- วิธีตรวจ: เปิดโหมดไม่ระบุตัวตนใน Chrome แล้วค้นหาคีย์เวิร์ดหลัก ๆ 3 คำ ถ้าคู่แข่งได้กรอบ Featured Snippet (กรอบคำตอบสีเทา) หรือขึ้นใน “People also ask” และเว็บเราตกไปอยู่อันดับ 2 ลงไป ก็แปลว่าทราฟฟิกอาจถูกแย่ง

- เคส: เว็บเครื่องมือแปลง PDF เคยได้ Featured Snippet จากคีย์ “PDF converter” แต่คู่แข่งทำเพจที่เรียงขั้นตอนเป็น “① อัปโหลด → ② เลือกรูปแบบ → ③ ดาวน์โหลด” พร้อมตารางเปรียบเทียบ จนชิงทราฟฟิกไปได้ 35% ภายใน 7 วัน

- วิธีสู้กลับ: ใช้ AnswerThePublic หา Long-tail Question แล้วเพิ่ม Q&A และลิสต์แบบมีหมายเลขพร้อมหัวข้อ H2/H3 ลงในเพจ

2. เปรียบเทียบความถี่ในการอัปเดตคอนเทนต์ของคู่แข่ง (ใช้ Screaming Frog)

- วิธีเก็บข้อมูล: ใส่โดเมนคู่แข่งลงใน Screaming Frog แล้วกรองด้วย “Last Modified” เพื่อดูว่าดิเรกทอรีไหนมีการอัปเดตบ่อย ๆ ในช่วง 1 เดือนที่ผ่านมา เช่น ถ้า /blog/ ของเขาโพสต์วันละ 5 บทความ และหัวข้อไปชนกับของเรา ก็มีโอกาสที่เราถูก “โจมตีด้วยคอนเทนต์”

- ข้อควรระวัง: บางเว็บอาจแค่เปลี่ยนวันที่แสดงแต่ไม่ได้อัปเดตเนื้อหาจริง ๆ ควรใช้ Diffchecker เพื่อเทียบเนื้อหาดู

- แนวทางตอบโต้: สำหรับหัวข้อที่โดนรุม ควรทำรายงานแบบมีข้อมูลวิจัย วิดีโอสอนใช้ หรือกราฟเปรียบเทียบเครื่องมือ เพื่อต่อสู้ด้วยคุณภาพ

3. ตรวจว่าถูกแย่งทราฟฟิกจากโฆษณาหรือไม่ (ดูประวัติโฆษณาจาก SpyFu)

- เครื่องมือตรวจสอบ: ใช้ SpyFu ใส่โดเมนคู่แข่ง แล้วดู “Ad History” ว่าช่วงทราฟฟิกลดมีการยิงโฆษณาด้วยชื่อแบรนด์หรือคีย์เวิร์ดหลักของเราหรือเปล่า ถ้าใช่ แปลว่าคู่แข่งจงใจยิงโฆษณาแย่งทราฟฟิก

- เก็บหลักฐาน: ใช้ SEMrush หรือแพลตฟอร์มดูตัวอย่างโฆษณา จับภาพคำโฆษณาที่เปรียบเทียบเรา เช่น “ถูกกว่า XXX” แล้วแจ้ง Google ว่าเป็นการละเมิดนโยบายโฆษณาเปรียบเทียบ

- วิธีป้องกัน: ตั้งค่า Exclude Keyword ใน Google Ads สำหรับชื่อแบรนด์ของเรา และเพิ่มตรา “ยืนยันตัวตน” บน Landing Page เพื่อสร้างความเชื่อมั่น

ปกติแล้วการฟื้นตัวของทราฟฟิกจะใช้เวลาประมาณ 1–3 เดือน อย่าส่งคำขอพิจารณาใหม่บ่อยเกินไป เพราะอาจถูกมองว่าเราพยายามหลอกระบบ