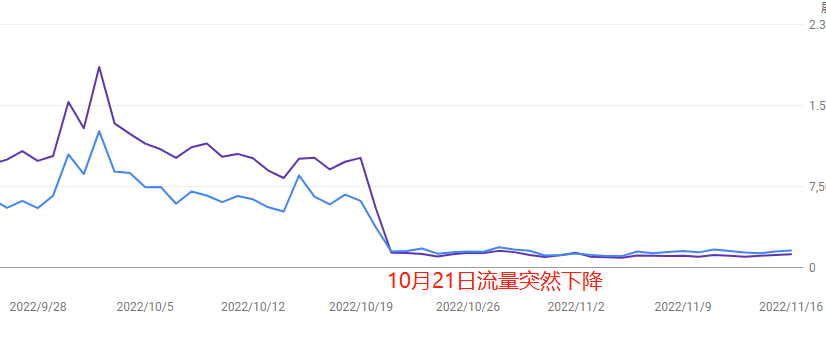

Недавно трафик сайта резко вырос, а затем так же резко упал. Первая реакция у многих вебмастеров: “Неужели Google снова обновил алгоритм?”

Но на самом деле, за резкими скачками трафика может стоять сразу несколько причин — возможно, это побочный эффект обновления алгоритма, а может быть проблема в технических сбоях на сайте, низком качестве контента или даже целенаправленных действиях конкурентов.

В этой статье с практической точки зрения мы разберёмся, как самостоятельно быстро проверить — дело в алгоритме или «пожар начался в собственном дворе», чтобы не допустить ошибочного редизайна, который может только усугубить ситуацию.

Table of Contens

ToggleСначала проверьте, действительно ли это из-за обновления алгоритма Google

Когда трафик резко проседает, большинство вебмастеров автоматически думают: «Google опять обновил алгоритм!»

Но если сразу всё списывать на алгоритм, можно пропустить более очевидные и серьёзные проблемы.

1. Проверьте официальный календарь обновлений Google (ссылка на блог Search Central)

- Что делать: перейдите в официальный блог Google Search Central (по ссылке), откройте раздел “What’s new in Google Search” и посмотрите, что обновлялось за последние 3 месяца. Обновления ядра обычно помечаются как “Core Update”, а тематические изменения (например, по обзорам или EEAT) выделяются отдельно.

- На что обратить внимание: мелкие обновления (например, борьба со спам-ссылками) могут не анонсироваться, поэтому лучше сверять с показателями SEO-инструментов.

- Пример: во время Core Update в августе 2023 года многие сайты в медицинской и финансовой нише потеряли 30%-50% трафика из-за нехватки авторитетности контента.

2. Используйте SEO-инструменты, чтобы определить момент колебаний (рекомендуемые бесплатные: SEMrush Sensor, RankRanger)

- Практический приём: в SEMrush Sensor посмотрите показатель “волатильности” за 3 дня до падения трафика. Если значение выше 7 — значит что-то происходит. Например: трафик сайта с инструментами 5 сентября просел на 40%, при этом 3 сентября Sensor показывал 8.2 — совпало с невидимым апдейтом против спама.

- Перекрёстная проверка: также зайдите в Google Search Console и проверьте график изменений позиций. Если спад кликов совпадает с пиком на Sensor — вероятность влияния алгоритма высокая.

3. Сравните данные конкурентов (графики SimilarWeb)

- Как проверить: на SimilarWeb введите 3 домена конкурентов, включите график “Organic Traffic”. Если у всех в одно время схожий спад (например, -20% и больше), вероятнее всего, это отраслевое обновление алгоритма. Если же упал только ваш сайт — ищите проблему внутри.

- Неочевидный вывод: в некоторых нишах (например, обзоры хостингов) топовые сайты могут наоборот вырасти за счёт обновления — поэтому анализируйте не 2–3, а хотя бы топ-10 сайтов в вашей теме.

Срочно проверьте технические сбои на сайте

На устранение технических ошибок есть примерно 48 часов. Если затянуть — позиции могут упасть надолго.

1. Проверка состояния сервера (на примере Pingdom)

- Как действовать: зайдите на Pingdom или UptimeRobot (в бесплатной версии — проверка каждые 2 минуты), и посмотрите, были ли “Downtime” (обозначены красным) в момент падения трафика. Например: сайт e-commerce упал на 3 часа во время распродажи — потеря 60% органического трафика.

- На заметку: сбои на стороне CDN (например, Cloudflare) могут касаться только отдельных регионов. Используйте Geopeeker, чтобы протестировать доступность сайта из разных стран.

- Экстренные меры: при обнаружении простоя сразу обращайтесь к хостеру для расширения ресурсов или переноса, и отправьте в GSC запрос на переобход “битых ссылок”.

2. Проверка скорости загрузки страницы (со скриншотом PageSpeed Insights)

- Ключевые метрики: используйте Google PageSpeed Insights для анализа проблемных страниц. Особое внимание — на показатель LCP (Largest Contentful Paint), он должен быть ниже 2.5 секунд. Если мобильный показатель ниже 50 — сайт может терять позиции из-за плохого “опыта страницы”.

- Пример: блог не сжал изображения на главной (одно изображение — 3 МБ), в итоге загрузка на мобильных — 8 секунд. Google снял страницу с топ-100.

- Что оптимизировать: сжать изображения (TinyPNG), включить отложенную загрузку для неважных элементов (плагин LazyLoad), убрать лишние CSS/JS-файлы (PurgeCSS).

3. Статистика ошибок сканирования (отчёт о покрытии в Google Search Console)

- Где искать ключевые данные: зайдите в GSC → Покрытие → вкладка «Ошибки», отфильтруйте критичные ошибки за даты до и после падения трафика, такие как «URL, заблокированные в robots.txt» или «таймаут сервера (5xx)». Если количество ошибок за день выросло более чем на 200%, это может привести к резкому снижению индексации.

- Неочевидная ловушка: после обновлений некоторых плагинов WordPress может случайно измениться файл robots.txt (например, начать блокировать путь /admin), что перекрывает доступ к сканированию всего сайта.

- Что можно сделать срочно: вручную запросить срочное сканирование через инструмент «Проверка URL» в GSC и после исправления отправить на «проверку устранения».

Алгоритм “мстит” за низкое качество контента

Самая коварная причина падения трафика — это сам контент. Возможно, вы временно получили трафик с посредственным или ИИ-сгенерированным контентом, но Google с помощью BERT, MUM и других ИИ-моделей стал хорошо выявлять такие страницы с «отложенным наказанием».

Обычно это случается через 1–2 недели после обновления алгоритма, а восстановление может занять месяцы.

1. Проверка доли AI/скопированного контента (рекомендуется вручную проверить 20% страниц)

- Инструменты для проверки: используйте Originality.ai или GPTZero для анализа страниц с высоким показателем отказов — обращайте внимание на слишком «гладкие, но поверхностные» абзацы (например, типичная структура из 5 пунктов, частое использование связок).

- Пример: техноблог сгенерировал 50 статей “Как исправить XXX ошибку” с помощью ChatGPT. Вначале они хорошо ранжировались, но после обновления против спама в октябре 2023 трафик резко упал.

- Что делать: если на странице более 30% ИИ-контента — добавьте уникальные примеры, интервью пользователей и замените длинные текстовые описания (более 300 символов) на видео или инфографику.

2. Показатель отказов новых источников трафика (по отчётам GA4)

- Где искать данные: в GA4 откройте «Привлечение трафика → Страницы и экраны» и отфильтруйте страницы, которые появились в трафике за 30 дней до падения. Если показатель отказов выше среднего по сайту более чем на 15% (например, среднее — 50%, страница — 65%), это может снизить её рейтинг.

- Неочевидный момент: статьи в стиле кликбейта могут иметь высокий CTR, но если пользователь уходит менее чем за 10 секунд — алгоритм считает такой контент вводящим в заблуждение.

- Как улучшить: добавьте на такие страницы якорное меню, блоки с «похожими решениями» и другие элементы, увеличивающие вовлечённость.

3. Проверка качества недавно полученных внешних ссылок (по оценке спама от Ahrefs)

- На что смотреть: используйте Ahrefs и проверьте внешние ссылки, полученные за 2 месяца до падения трафика. Если «оценка спама» выше 40 из 100 или много ссылок с одного C-класса IP (например, 192.168.1.XX) — это может вызвать санкции.

- Опасный пример: туристический сайт купил 50 ссылок с форумов про казино в Камбодже, в результате чего весь сайт Google пометил как «ненадёжный источник».

- Как исправить: отправьте файл отклонения ссылок в GSC и удалите контент на сайте, связанный с темами, откуда шли вредоносные ссылки.

Целенаправленные действия конкурентов

Падение трафика может быть вызвано не только вашими ошибками — возможно, конкуренты вас просто обошли: забрали избранные сниппеты, начали активно публиковать похожий контент или просто запустили рекламу на те же ключевые запросы.

Органическая выдача Google — это игра с нулевой суммой. Когда один растёт — кто-то другой теряет.

1. Проверка, не перехватили ли конкуренты ваши избранные сниппеты (ручной поиск по ключевым словам)

- Что делать: в режиме инкогнито в Google введите свои Топ-3 ключевых слова. Если страница конкурента отображается в блоке Featured Snippet (серая рамка) или «Люди также спрашивают», а ваша — нет, значит, вас обошли.

- Пример: сайт по PDF-инструментам держал сниппет по ключу “PDF converter”, но конкурент добавил пошаговую инструкцию («1. Загрузить → 2. Выбрать формат → 3. Скачать») + таблицу сравнения и забрал 35% кликов за неделю.

- Как вернуть позиции: с помощью AnswerThePublic найдите дополнительные вопросы и добавьте модуль Q&A, структурируйте контент с заголовками H2/H3 и пошаговыми списками.

2. Проверка частоты обновлений у конкурентов (через Screaming Frog)

- Как проверить: введите домен конкурента в Screaming Frog, включите фильтр по «Last Modified» и проверьте, в каких разделах они публикуют чаще всего. Если в разделе /blog/ появилось по 5 новых статей в день — готовится массированная атака на вашу нишу.

- Осторожно: некоторые сайты просто меняют дату публикации без фактических изменений. Используйте Diffchecker для сравнения версий страниц и убедитесь, что контент действительно обновился.

- Что делать: создайте более ценные материалы — аналитические отчёты, видеоуроки, таблицы сравнения инструментов и т.д., чтобы выделиться качеством.

3. Возможная потеря трафика из-за рекламы конкурентов (проверка через историю рекламы SpyFu)

- Как проверить: введите домен конкурента на SpyFu, зайдите в раздел «Ad History» и посмотрите, запускал ли он в период вашего падения рекламу на ваши брендовые или ключевые слова (например, «[ваш бренд] + альтернатива»).

- Доказательства для жалобы: используйте SEMrush Advertising Research для скриншотов объявлений конкурента. Если в тексте есть фразы вроде «дешевле, чем XXX (ваш бренд)» — это нарушает политику сравнительной рекламы Google.

- Как защититься: добавьте в Google Ads «исключение брендовых ключей», а на посадочной странице укажите, что вы — «официальный источник», чтобы повысить доверие.

Восстановление трафика обычно занимает от 1 до 3 месяцев. Частые запросы на повторную проверку могут вызвать подозрение в «манипуляции вручную».