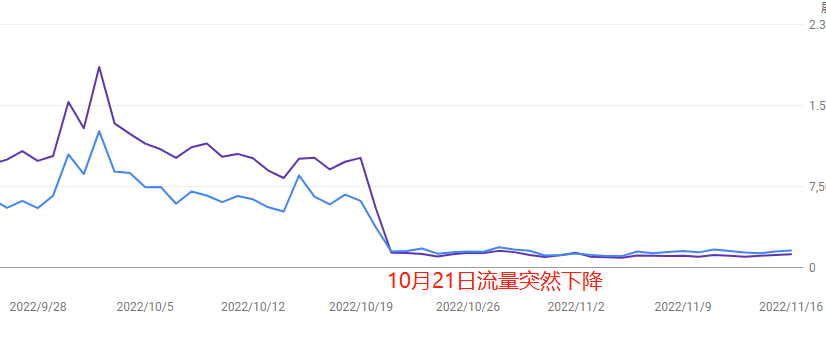

In letzter Zeit ist der Website-Traffic plötzlich stark angestiegen und dann wieder stark gefallen. Viele Webmaster denken sofort: „Hat Google wieder seinen Algorithmus aktualisiert?“

Doch in Wirklichkeit können die starken Schwankungen des Traffics durch verschiedene Faktoren gleichzeitig verursacht werden – es könnte eine „Kollateralschaden“ durch Algorithmus-Anpassungen sein, technische Fehler auf der eigenen Website, eine Abwertung wegen minderwertiger Inhalte oder sogar gezielte Angriffe von Konkurrenten.

Dieser Artikel zeigt praxisnah, wie man durch eine eigene Überprüfung schnell feststellen kann, ob der Traffic-Rückgang durch den Algorithmus bedingt ist oder ob „das eigene Haus brennt“. So vermeidet man, durch falsche Einschätzungen blind umzugestalten und dadurch eine noch stärkere Abwertung zu riskieren.

Table of Contens

ToggleZuerst prüfen, ob die Ursache ein Google-Algorithmus-Update ist

Wenn der Traffic plötzlich einbricht, reagieren Webmaster meist reflexartig und vermuten „Google hat wieder den Algorithmus geändert“.

Aber das blinde Zuschreiben an ein Algorithmus-Update kann dazu führen, dass man andere, direktere Probleme übersieht.

1. Google offizielle Update-Kalender checken (inkl. Link zum Search Central Blog)

- Vorgehen: Direkt den offiziellen Google Search Central Blog besuchen (Link), im Bereich „What’s new in Google Search“ die Updates der letzten 3 Monate ansehen. Core Updates sind meist mit „Core Update“ gekennzeichnet, Produktspezifische Updates (z.B. Kommentare, EEAT) werden separat erläutert.

- Vorsicht: Kleinere Updates (z.B. Spam-Link-Kampf) werden oft nicht öffentlich bekanntgegeben, hier sollte man Tool-Daten zum Traffic-Verlauf prüfen.

- Beispiel: Im Core Update August 2023 haben viele medizinische und Finanzseiten wegen mangelnder Autorität 30–50 % Traffic eingebüßt.

2. SEO-Tools zur Überwachung der Schwankungen nutzen (empfohlene kostenlose Tools: SEMrush Sensor, RankRanger)

- Praktischer Tipp: Im SEMrush Sensor den „Fluktuationsindex“ 3 Tage vor dem Traffic-Einbruch prüfen (ab 7 Punkten gilt es als ungewöhnlich). Beispiel: Eine Tool-Webseite verliert am 5. September 40 % Traffic, Sensor zeigt am 3. September einen Wert von 8,2 an – passend zu einem unbekannten Spam-Link-Kampf.

- Daten abgleichen: In der Google Search Console (GSC) die „Ranking-Änderungen“ beobachten. Wenn Klickrate und Sensor-Werte zeitlich zusammenfallen, ist ein Algorithmus-Update wahrscheinlich.

3. Vergleich mit Wettbewerber-Websites (Traffic-Kurven via SimilarWeb)

- Vorgehen: Auf SimilarWeb mindestens drei Konkurrenzdomains eingeben und „Organic Traffic“-Trends vergleichen. Fallen mehrere gleichzeitig >20 % Traffic, ist es wahrscheinlich ein branchenweites Algorithmus-Update. Nur dein Traffic fällt, sollte zuerst die eigene Seite geprüft werden.

- Gegenintuitive Erkenntnis: Manche Nischen (z.B. Hosting-Reviews) erleben dank Algorithmusschutz einen Traffic-Anstieg, daher sollte man auf die Top 10 Wettbewerber schauen.

Dringend technische Ausfälle prüfen

Das Zeitfenster zur Reparatur technischer Fehler liegt meist bei 48 Stunden, sonst kann das Ranking dauerhaft leiden.

1. Server-Status prüfen (Pingdom als Beispiel für Downtime-Check)

- Vorgehen: Auf Pingdom oder UptimeRobot (kostenlos, 2-Minuten-Intervalle) prüfen, ob in der Zeit des Traffic-Absturzes Ausfälle („Downtime“, rot markiert) aufgetreten sind. Beispiel: Ein Shop verliert während eines Sales wegen Serverüberlastung 3 Stunden lang 60 % Traffic.

- Vorsicht: CDN-Anbieter (z.B. Cloudflare) können regionale Störungen verursachen. Mit Geopeeker von verschiedenen Ländern testen.

- Notfallmaßnahme: Bei Downtime sofort Host kontaktieren, Server aufstocken oder wechseln und in GSC eine URL-Neucrawling-Anfrage stellen.

2. Ladegeschwindigkeit prüfen (mit PageSpeed Insights)

- Wichtige Kennzahl: Auf PageSpeed Insights die vom Traffic-Rückgang betroffenen Seiten testen. LCP (Largest Contentful Paint) sollte unter 2,5 Sekunden liegen. Mobile Scores unter 50 können zu Rankingverlusten wegen verschlechterter Nutzererfahrung führen.

- Beispiel: Ein Blog lädt auf Mobilgeräten 8 Sekunden wegen 3MB großen Bildern, fällt aus den Top 10 direkt raus.

- Optimierung: Bilder komprimieren (TinyPNG), Lazy Load für nicht sichtbare Inhalte aktivieren (LazyLoad Plugin), unnötiges CSS/JS entfernen (PurgeCSS).

3. Crawling-Fehler prüfen (Google Search Console Coverage Report)

- Datenquelle: In GSC unter „Coverage“ → „Errors“ nach Fehlern wie „URL durch robots.txt blockiert“ oder „Serverfehler 5xx“ suchen, besonders in der Zeit des Traffic-Einbruchs. Ein Anstieg der Fehler um 200 % an einem Tag kann die Indexierung massiv beeinträchtigen.

- Fallstrick: Manche WordPress-Plugins ändern nach Updates die robots.txt und blockieren dadurch versehentlich den gesamten Zugriff.

- Notfalllösung: URL-Inspektor in GSC nutzen, manuell Crawling anstoßen und nach Fehlerbehebung „Fix validieren“ klicken.

3. Crawling-Fehlerstatistik (Google Search Console Abdeckungsbericht)

- Wichtige Datenermittlung: Gehen Sie zu GSC → Abdeckung → Tab „Fehler“, filtern Sie nach „Von robots.txt blockierte eingereichte URLs“, „Server-Timeouts (5xx)“ und anderen kritischen Fehlern rund um das Datum des Traffic-Einbruchs. Wenn die Crawling-Fehler an einem Tag um mehr als 200 % steigen, kann dies zu einem starken Rückgang der Indexierung führen.

- Ungewöhnliche Fallen: Manche WordPress-Plugin-Updates ändern versehentlich die robots.txt-Datei (z. B. plötzlich Blockierung des /admin-Pfads), was die gesamte Website-Crawling-Berechtigung sperrt.

- Vorübergehende Gegenmaßnahmen: Manuelles Notfall-Crawling im GSC „URL-Prüftool“ anfordern und nach Behebung den Status „Fix bestätigt“ einreichen.

Qualitätsprobleme des Inhalts durch algorithmische „Nachträgliche Abrechnung“

Der versteckteste „Falle“ für Traffic-Einbrüche liegt oft im Inhalt selbst – vielleicht haben Sie kurzfristig mit minderwertigem Content Traffic gewonnen, aber Google verbessert dank BERT, MUM und anderen KI-Modellen zunehmend die „späte Bestrafung“ für Plagiate, KI-aufgeblähte oder überoptimierte Seiten.

Diese „nachträgliche Abrechnung“ erfolgt meist 1–2 Wochen nach Algorithmus-Updates und die Erholung kann Monate dauern.

1. Anteil von KI-generierten/gesammelten Inhalten prüfen (Empfehlung: manuelle Stichprobe von 20 % der Seiten)

- Erkennungstools: Nutzen Sie Originality.ai oder GPTZero, um Seiten mit hoher Absprungrate zu scannen. Achten Sie besonders auf Absätze, die „zu flüssig, aber oberflächlich“ wirken (z. B. durchgehend fünf-Absatz-Struktur, wiederholte Verbindungswörter).

- Beispiel: Ein Tech-Blog hat mit ChatGPT 50 Tutorials „Wie man XXX-Fehler behebt“ automatisch erstellt, anfangs stabile Rankings, aber im Oktober 2023 durch Google’s Spam-Bestrafung halbierten sich die Besucherzahlen.

- Notfallmaßnahmen: Für Seiten mit mehr als 30 % KI-Inhalt sofort exklusive Fallstudien, Nutzerinterviews usw. ergänzen und über 300 Wörter reinen Text durch Videos/Grafiken ersetzen.

2. Absprungrate neuer Traffic-Quellenseiten (GA4-Verhaltensbericht zum Vergleich)

- Datenfindung: Im GA4-Bericht „Akquisition → Seiten & Bildschirme“ neue Einstiegsseiten der letzten 30 Tage vor Traffic-Einbruch filtern. Liegt die Absprungrate dort um mehr als 15 % über dem Website-Durchschnitt (z. B. Website-Durchschnitt 50 %, Seite 65 %), könnte Google das Ranking abwerten.

- Ungewöhnliches Phänomen: Manche „Clickbait“-Artikel haben hohe Klickzahlen, aber Verweildauer unter 10 Sekunden und werden vom Algorithmus als irreführender Content gewertet.

- Optimierungstipps: Auf minderwertigen Seiten „Inhaltsverzeichnis-Anker“ und „relevante Lösungsvorschläge“ als Pop-ups einfügen, um die Interaktionszeit der Nutzer zu verlängern.

3. Plötzliche Qualitätsprüfung eingehender Backlinks (Ahrefs-Spam-Score-Standard)

- Risikoindikatoren: Mit Ahrefs neue Backlinks der letzten 2 Monate vor Traffic-Einbruch prüfen. Wenn der Spam-Score über 40 (max. 100) liegt oder viele Links von derselben C-Klasse-IP kommen (z. B. 192.168.1.XX), kann das eine Algorithmus-Strafe auslösen.

- Gefährliches Beispiel: Eine Reise-Seite kaufte 50 Forenlinks zum Thema „Kambodscha Casinos“, was zur Kennzeichnung der gesamten Seite als „unzuverlässige Quelle“ durch Google führte.

- Schadensbegrenzung: „Disavow“-Datei bei Google Search Console hochladen und Inhalte, die thematisch stark mit Spam-Backlinks verbunden sind, löschen.

Gezielte Aktionen von Wettbewerbern

Traffic-Einbrüche sind nicht immer Ihre Schuld, manchmal „schleichen“ Wettbewerber sich ein – stehlen Ihre Featured Snippets, aktualisieren stark ähnliche Inhalte oder lenken mit Werbebudgets Traffic ab.

Google-Rankings sind ein Nullsummenspiel. Wenn Konkurrenten plötzlich Gas geben, wird Ihr Traffic oft „präzise zerlegt“.

1. Haben Konkurrenten Ihre Featured Snippets geklaut? (Manuelle Suche nach Kern-Keywords)

- Vorgehen: Suchen Sie im Inkognito-Modus bei Google nach Ihren Top-3-Traffic-Keywords. Erscheinen Wettbewerber im „Featured Snippet“ (grauer Kasten mit Antwort) oder „People also ask“-Bereich und Ihre Seite ist erst auf Platz 2, ist das ein typischer Traffic-Diebstahl.

- Beispiel: Ein Tool-Portal hatte für das Kernkeyword „PDF converter“ das Featured Snippet, aber Wettbewerber schnappte es sich innerhalb von 7 Tagen mit Schritt-für-Schritt-Listen („1. Datei hochladen → 2. Format auswählen → 3. Download mit einem Klick“) plus Vergleichstabellen und gewann 35 % Klicks.

- Gegenstrategie: Mit AnswerThePublic Longtail-Fragen finden, auf der Seite „Q&A“-Module hinzufügen und nummerierte Schritte plus H2/H3-Überschriften verwenden.

2. Vergleich der Update-Frequenz bei Wettbewerbern (mit Screaming Frog)

- Datenerhebung: Geben Sie bei Screaming Frog die Domain der Wettbewerber ein, filtern Sie nach „Last Modified“, um kürzliche Updates (innerhalb 1 Monat) in bestimmten Verzeichnissen zu sehen. Wenn ein Konkurrent täglich 5 Beiträge im /blog/-Verzeichnis postet und die Themen Ihre Topsiten treffen, sollten Sie vorsichtig sein.

- Warnung: Manche Wettbewerber fälschen Updates (nur Datum geändert, Inhalt unverändert). Mit Diffchecker können Sie alte Versionen vergleichen und echte Änderungen prüfen.

- Antwort: Veröffentlichen Sie tiefgehende Berichte (Branchenforschung, Video-Tutorials, Toolvergleiche), um die Content-Differenz zu vergrößern.

3. Mögliche Traffic-Abzweigung durch Anzeigen (SpyFu-Werbehistorie)

- Überprüfung: Geben Sie die Domain des Konkurrenten bei SpyFu ein, schauen Sie im Bereich „Ad History“ nach Google Ads, die während des Traffic-Einbruchs laufen. Wenn dort Anzeigen mit Ihren Marken- oder Core-Longtail-Keywords auftauchen (z. B. „Ihr Markenname + Ersatz“), handelt es sich um böswilliges Bieten.

- Beweise: Mit PPC-Anzeigenvorschau-Tools (wie SEMrush Advertising Research) Screenshots von Anzeigen machen. Wenn der Text z. B. „billiger als XXX (Ihre Marke)“ enthält, können Sie Google wegen Verstoß gegen die „Vergleichende Werbung“ melden.

- Schnelle Gegenmaßnahmen: Für die betroffenen Keywords bei Google Ads Negativ-Keywords einrichten und auf der Landingpage „offizielle Zertifizierung“ hinzufügen, um Vertrauen zu stärken.

Die Traffic-Erholung braucht oft 1–3 Monate. Zu viele erneute Prüfungsanfragen können als „manuelle Eingriffe“ gewertet werden.